随着人工智能的发展,计算机在识物辨人等方面的能力与人类水平的差距逐渐缩小,而如何使计算机具备审美能力则仍然是一个很有挑战性的难题。图像美学质量评估(Image Aesthetics Assessment,IAA)就是希望通过计算机来模拟人类视觉系统对图像美观程度的度量,可将其应用于图像检索、照片增强、推荐等任务中。

近期,清华大学徐昆副教授和博士生折栋宇与英国卡迪夫大学来煜坤教授和腾讯易高雄研究员合作,提出了一种基于层次布局感知图卷积网络的图像美学评估方法,在三个图像美学评估子任务中性能均显著超过现有方法。该研究成果已被CVPR 2021接收[1],并在Jittor框架上开源。基于Jittor框架下的前向预测性能相比于PyTorch框架,推理速度提升约35%。

Part 1

图像美学评估从CNN到GCN

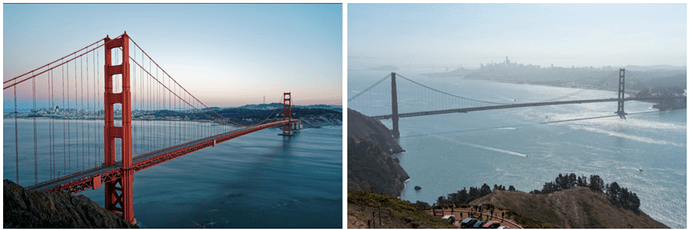

不同于传统物体识别任务,图像美学评估需不仅涉及到高层的语义信息,还与图像中的底层信息如布局构图、光影、色彩等等因素密不可分。下图展示了一组对比示例,可以看出即使拍摄的是相同的场景,所呈现出的图像美感也有很大差别。

图1 不同图像美学质量对比示例

现有的图像美学评估工作大多基于深度学习,利用卷积神经网络CNN来学习从图像到美学类别的映射,但其中面临着预处理和感受野有限两大问题。

现有工作[2,3]大多通过一些预处理手段(如剪裁、拉伸、填充、分块等)将输入图像处理至固定尺寸,但此类操作会影响原图的构图信息从而改变图像美学,反而为模型训练引入噪声。此外,CNN所采用的卷积操作由于感受野小,因而捕捉图像中较远区域之间关系的能力有限。

为了解决上述问题,作者提出了一种基于层次布局感知图卷积网络(HLA-GCN)来捕捉图像当中的视觉美学表征,和普通卷积操作相比,图卷积网络GCN的性质更适合于捕捉不同节点(图像区域)间的复杂关系,相比现有工作鲁棒性和效果更好。

Part 2

HLA-GCN模型框架

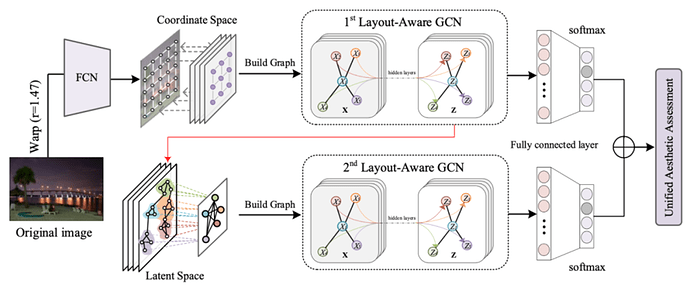

图2展示了HLA-GCN方法的整体流程图,在第一层网络中,给定输入图像,首先对其进行保留长宽比信息的缩放,将全卷积层提取的特征图视作节点特征,并构建考虑美学属性的无向全联通图,利用第一层布局感知图卷积模块(LA-GCN)在坐标系空间中通过图卷积进行信息传递;将节点映射至隐空间后,利用第二层LA-GCN模块在聚合的节点上实现更高效的图卷积,最终模型通过融合两层网络的输出来进行美学质量估计。

图2 图像美学质量评估方法HLA-GCN的网络结构设计

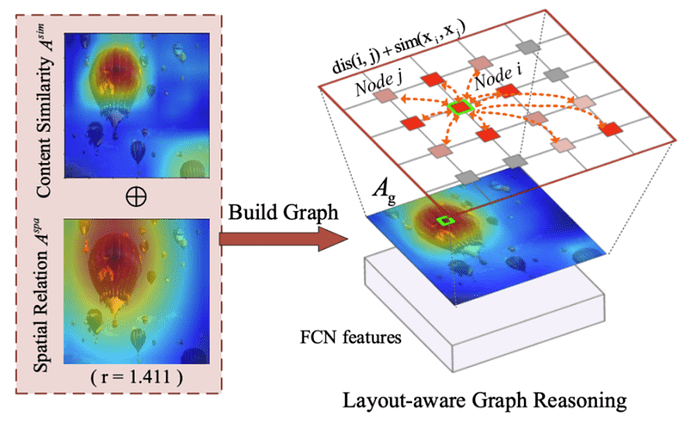

布局感知的图卷积过程如图3所示,首先基于空间中的节点构建无向全联通图,在计算任意两个节点间的权重时,同时考虑节点特征间的内容相似性,以及还原原始长宽比后的空间位置关系。根据计算得到的邻接矩阵,则可以在节点间通过图卷积传递信息并更新节点特征。

图3 保留布局信息的图信息传播过程

Part 3

实验结果

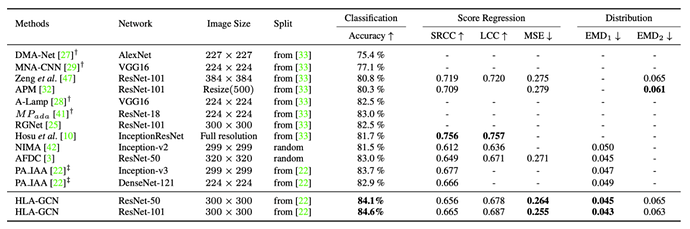

HLA-GCN在图像美学评估基准数据集AVA及AADB数据集上均进行了验证,实验证明所提方法在美学分布预测、美学分数回归以及美学分类三个子任务中均达到了现有支持批训练方法的最好效果。更多的消融实验可以阅读原论文。

表1 在AVA数据集上的图像美学评估实验结果

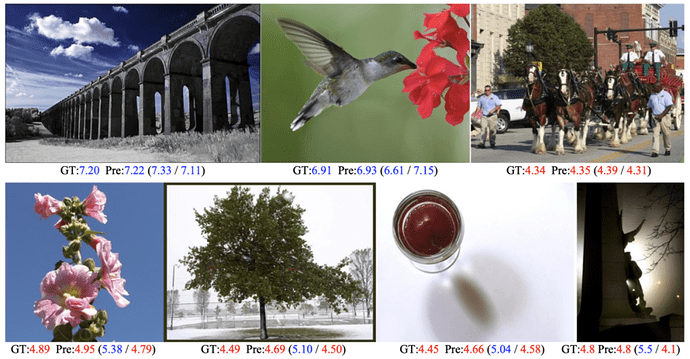

下图展示了HLA-GCN方法在AVA数据集上的部分预测结果(Pre)和真实标注(GT)。

图4 在AVA数据集上的图像美学分数预测结果

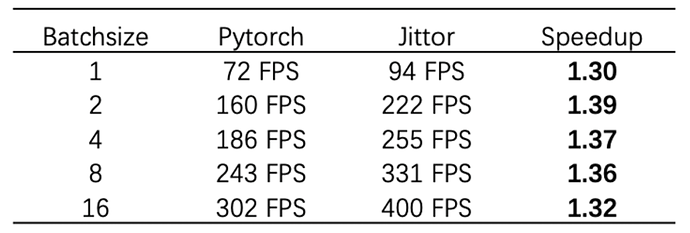

该论文提供了基于清华大学自主研发的“计图” (Jittor) 框架的推理代码,下表给出了Jittor框架和PyTorch框架在不同batchsize时模型推理的性能对比。

表2 Jittor和PyTorch框架对前向预测的性能对比

在图卷积模型上Jittor框架比Pytorch代码更精简且推理速度更快,可以看出Jittor框架推理速度相比Pytorch平均提升约35%。

有关论文的更多细节,及论文、代码下载,请浏览项目主页:

参考文献

- Dongyu She, Yu-Kun Lai, Gaoxiong Yi and Kun Xu, Hierarchical Layout-Aware GraphConvolutional Network for Unified Aesthetics Assessment, CVPR 2021.

- Hossein Talebi Esfandarani and Peyman Milanfar, NIMA: Neuralimage assessment, IEEE Transactions on Image Process, Vol. 27, No. 8, 2018, 3998-4011.

- Vlad Hosu, Bastian Goldlücke, Dietmar Saupe, Effectiveaesthetics prediction with multi-level spatially pooled features, CVPR 2019, 9367-9375.